¥

支付方式

请使用微信扫一扫 扫描二维码支付

请使用支付宝扫一扫 扫描二维码支付

计算机视觉基础入门课程(从算法到实战应用)

![]() 开通会员,立省699元

立即开通

开通会员,立省699元

立即开通

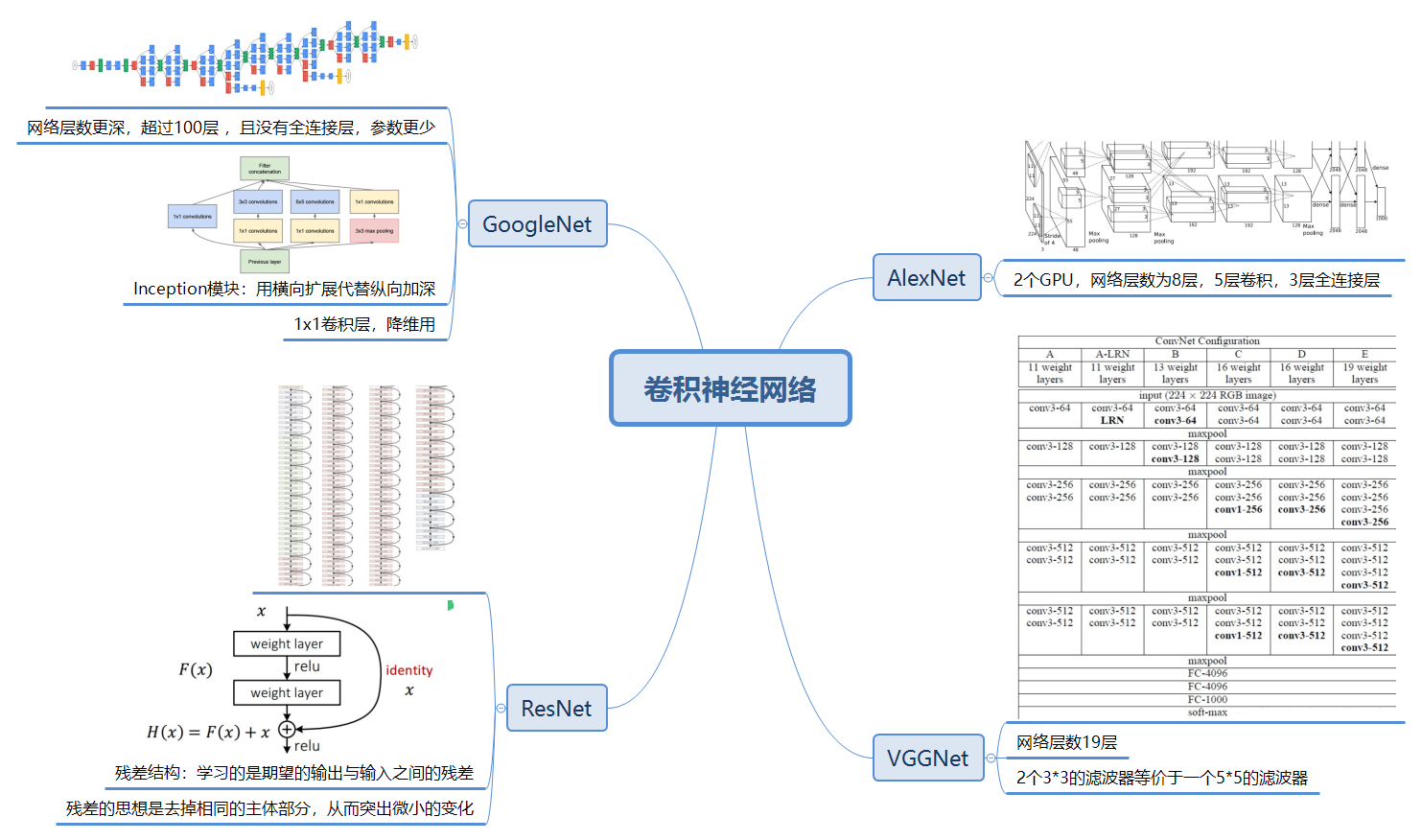

卷积神经网络

AlexNet,VGGNet,GoogleNet,ResNet

卷积、池化、全连接、softmax

VGGNet层数更多,VGG16具有16个权重层

VGGNet中采用3x3代替AlexNet中的11x11,两个3x3的滤波器等价于一个5x5的滤波器,((w-3)/1+1-3)=(w-5)/1+1,但是需要学习的参数变少了。feature map的尺寸不断减小,但是个数增多。

GoogleNet更深,没有全连接层,参数减少。增减inception模块,用横向扩展取代纵向加深。

ResNet:学习的是期望的输出与输入之间的残差。能够只能增加到很深的层数。

训练技巧、防止过拟合:

1、数据增强:水平翻转、随机裁剪和平移、颜色、光照变换

2、Dropout

3、 L1、L2正则化

4、Batch Normalization 批归一化

-

图像分类

-

神经网络原理

-

卷积神经网络介绍

-

利用caffe搭建深度网络做图像分类

-

神经网络的构成:参考机器学习内容

-

卷积滤波的计算,输出尺寸=(输入尺寸+2*pad-kernel_size)/步长+1

-

池化层(pooling layer)最大值池化:特征更加紧凑,同时具有位移不变性

-

全连接层:作为输出层

-

AlexNet

-

VGGNet

-

GoogleNet

-

ResNet

AlexNet : 5 个卷积层 2 个全连接层

VGGNet : 层数更多, feature map 维度不断在增加尺寸在减少

GoogleNet : 使用了1*1的卷积,用来降维

average pooling

ResNet : 使用残差模块,突破了深度极限

训练技巧 - 预处理:

1. 数据增强(Data augumentation):

水平翻转, 随机裁剪, 平移变换, 颜色光照变化

训练技巧 - 防止过拟合:

2. Droupt

其他技巧:

1. 正则化

2. batch Normalization

caffe :

主要的组成部分 Blob layer Net

深度学习网络:

AlexNet、VGGNet、GoogleNet和Resnet

vggnet滤波器的尺寸减小但个数增加,深度增加;

GOOGLEnet发明了inception网络的宽度增加,去掉了全连接层,降低参数;

Resnet发明了参差层,网络的深度急剧增加,避免了梯度消失。

1. 卷积神经网络介绍

2. 用caffe实战——图像分类

【问题1】卷积核大小的选择动机?

【问题2】con3-64?

3X3的卷积核,64通道

【问题3】什么是残差网络?

H(x) = F(x) + x

例:

5映射到5.1

F'(5)=5.1

H(5)=F(5)+5=5.1

F(x)=0.1

F'为引入残差前的映射,F为引入残差后的映射

【问题4】为什么说FC的参数过多,容易过拟合?

【问题5】怎么理解不同平台下(caffe版)的Alexnet的权重?

AlexNet:5个卷机层、2个全连接层

VGGNet:

GoogleNet:

趋势:层数越来越多、深度越来越深、卷积核尺寸越来越小、参数越来越少

客服1

客服1

官方群

官方群