输入x—卷积层conv1—激活层relu(求和)

—池化层maxpool2d(二维)

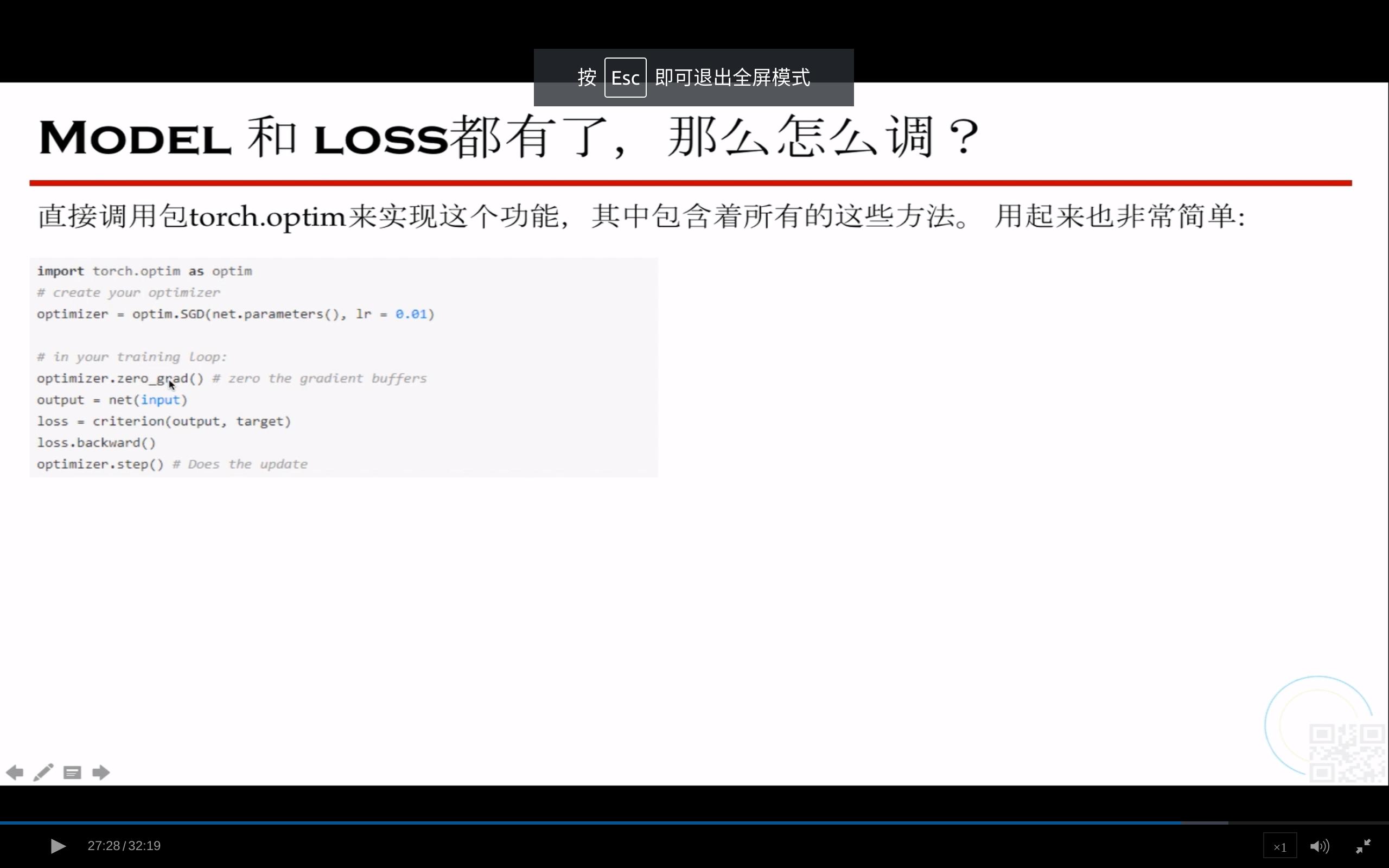

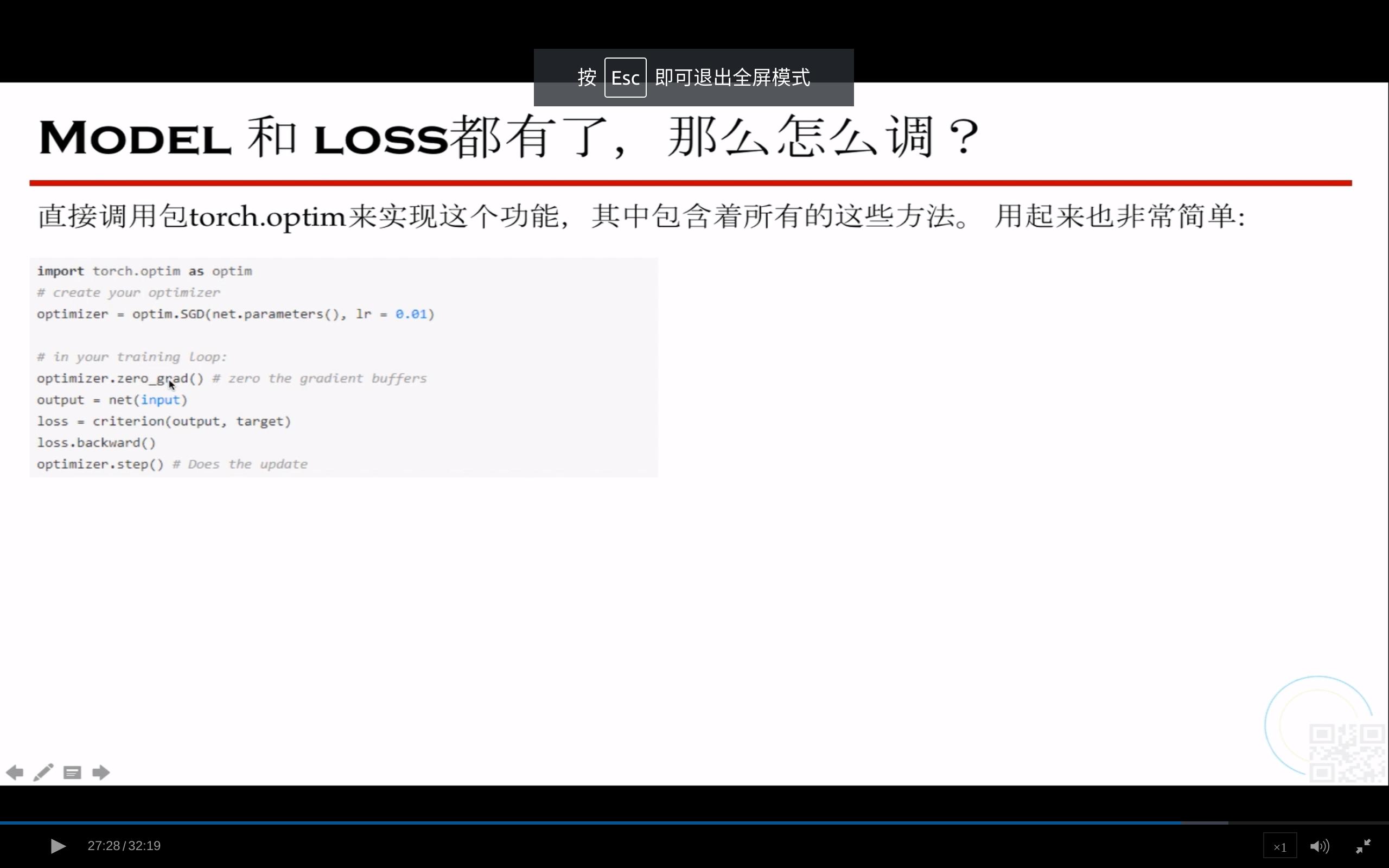

loss函数的作用:描述模型的预测值与真实值之间的差距大小

指导模型在训练过程中朝着收敛的方向前进。

¥

支付方式

请使用微信扫一扫 扫描二维码支付

请使用支付宝扫一扫 扫描二维码支付

![]() 开通会员,立省599元

立即开通

开通会员,立省599元

立即开通

输入x—卷积层conv1—激活层relu(求和)

—池化层maxpool2d(二维)

loss函数的作用:描述模型的预测值与真实值之间的差距大小

指导模型在训练过程中朝着收敛的方向前进。

关于PyTorch

命令行编程时PyTorch的关键特性

Mac下安装: