一、自然语言处理具体应用领域:

- (文字或语言)检索

- 在线广告匹配

- 自动(辅助)翻译

- 语音识别

- 聊天/对话代理

- 自动客服

- 设备控制

- 订购商品

二、基于深度学习的自然语言处理还可以应用于:

- 文本分类/情感分析

- 问答/对话/图像问答/基于图像的对话

- 机器翻译

- 图像描述生成

三、深度学习与人工智能的关系:人工智能是宏观上的概念,从技术上来说,主要是用到了机器学习技术,而机器学习中有一种算法是神经网络算法,神经网络是分层的,当层数大于3层时,我们一般就把这样的网络称为深度网络,而目前的深度学习算法就是经过一定的预处理之后,训练深度网络的算法。目前主要有卷积神经网络与循环神经网络。

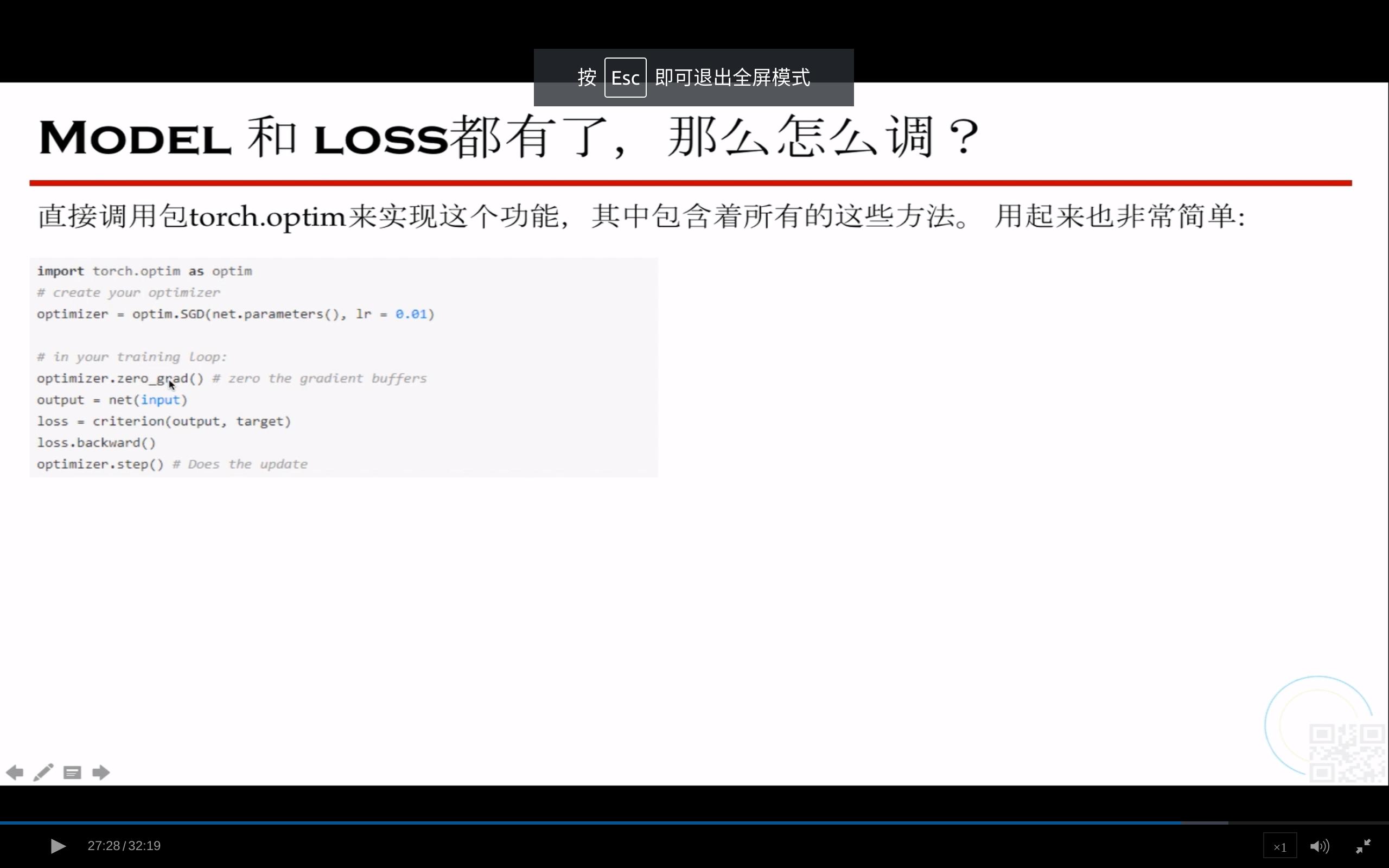

四、本课程以应用为主,结合了两种常用的深度网络,且主要是循环神经网络,通过Pytorch(一种实现深度学习算法的框架)来完成某些特定的与自然语言处理相关的内容。

客服1

客服1

官方群

官方群