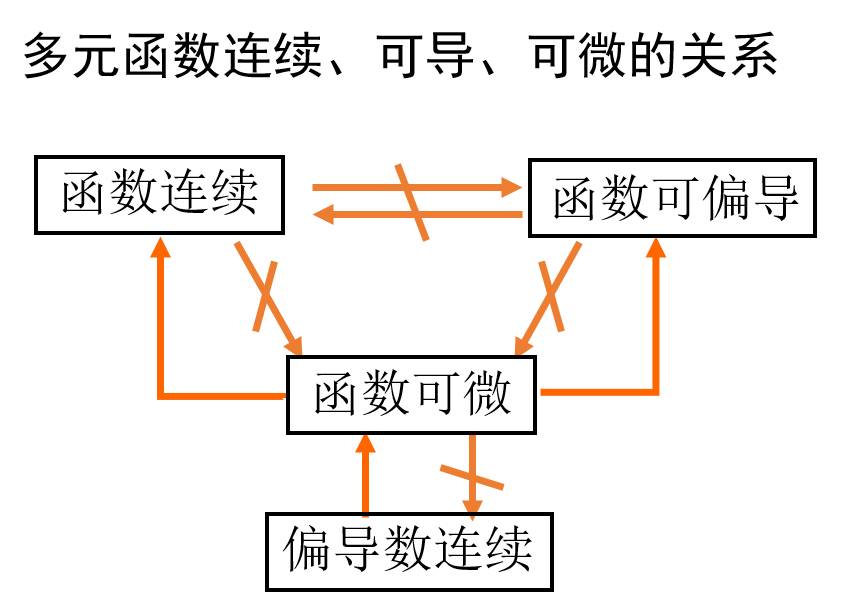

这节课的基本概念在标题里已经涵盖,对课程中的重点做了一下归纳,需要注意的几点:

¥

支付方式

请使用微信扫一扫 扫描二维码支付

请使用支付宝扫一扫 扫描二维码支付

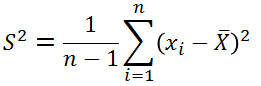

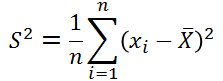

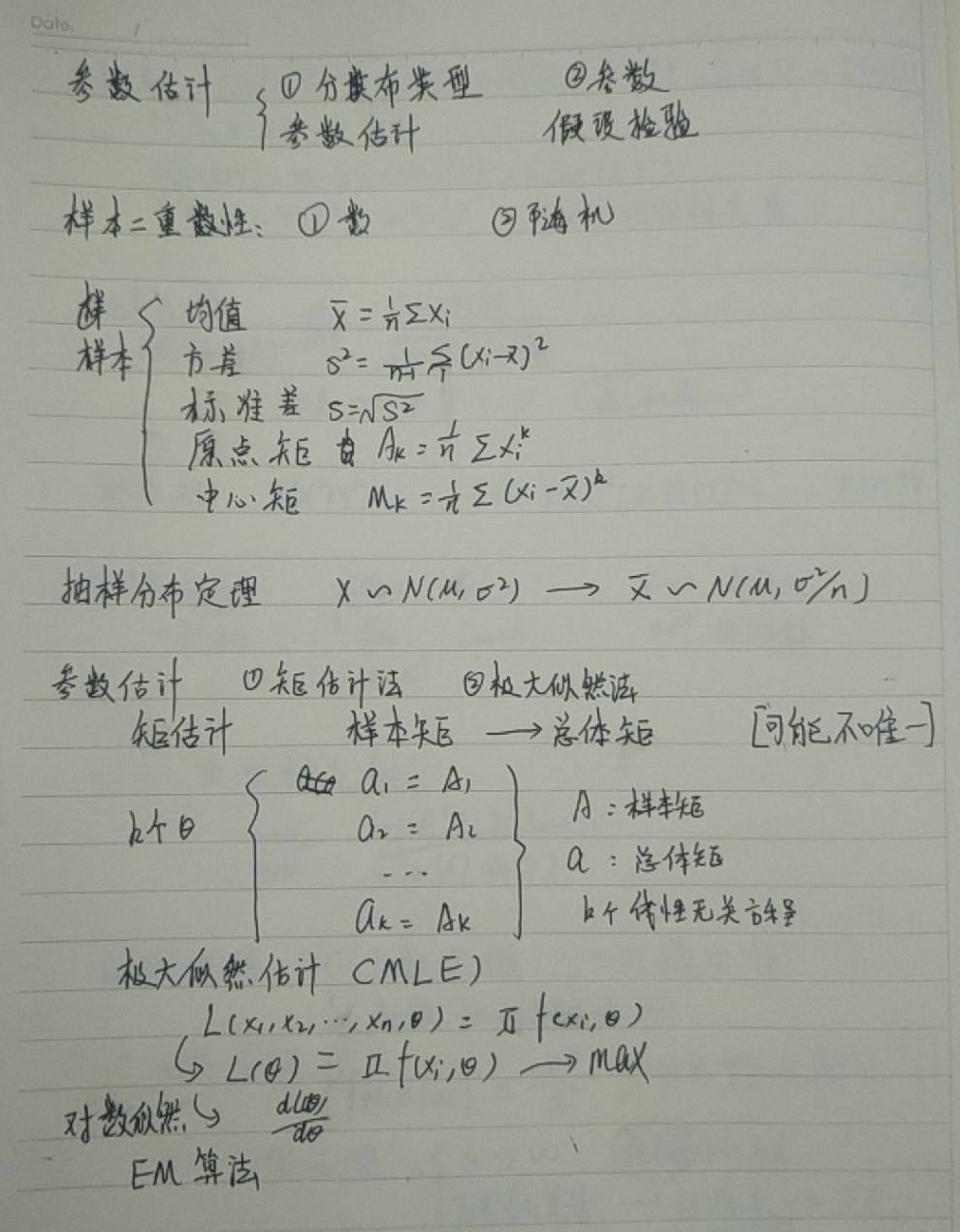

关于样本方差的无偏估计为什么是

而不是

这篇博文有做详细的推导证明https://blog.csdn.net/qq_39521554/article/details/79633207

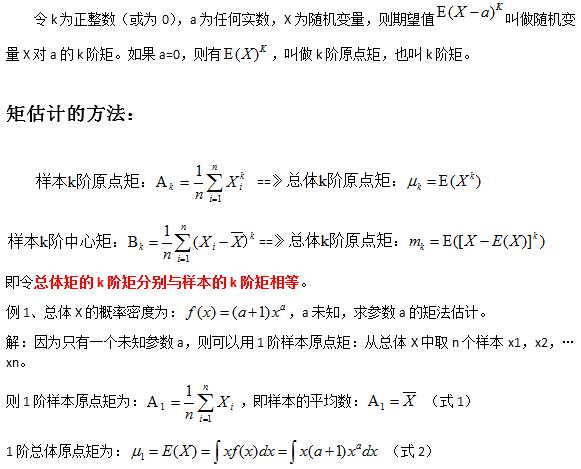

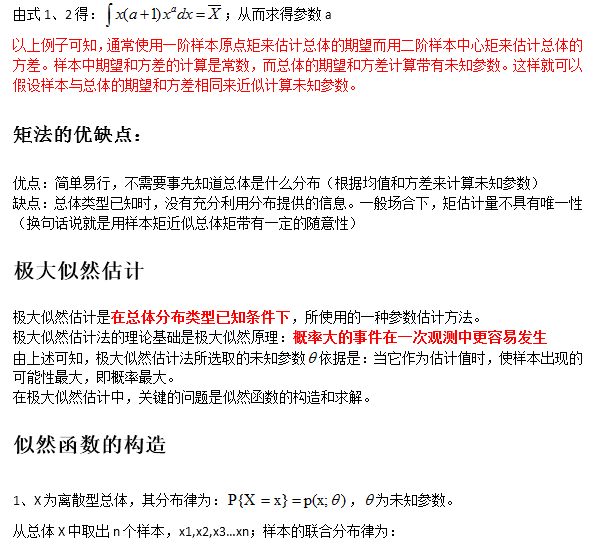

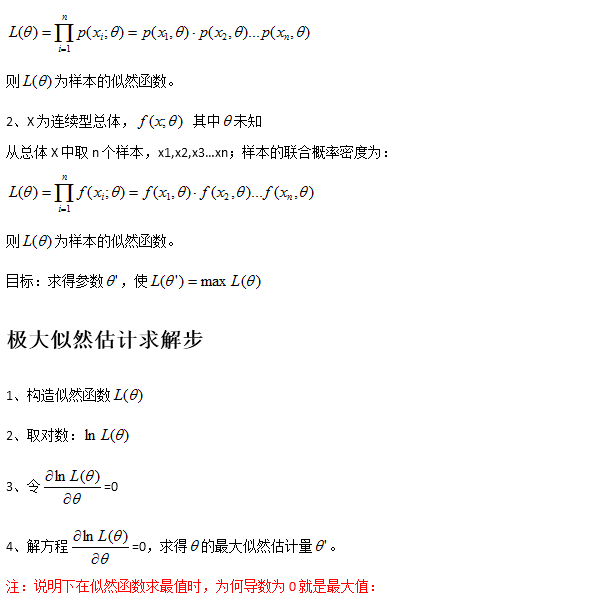

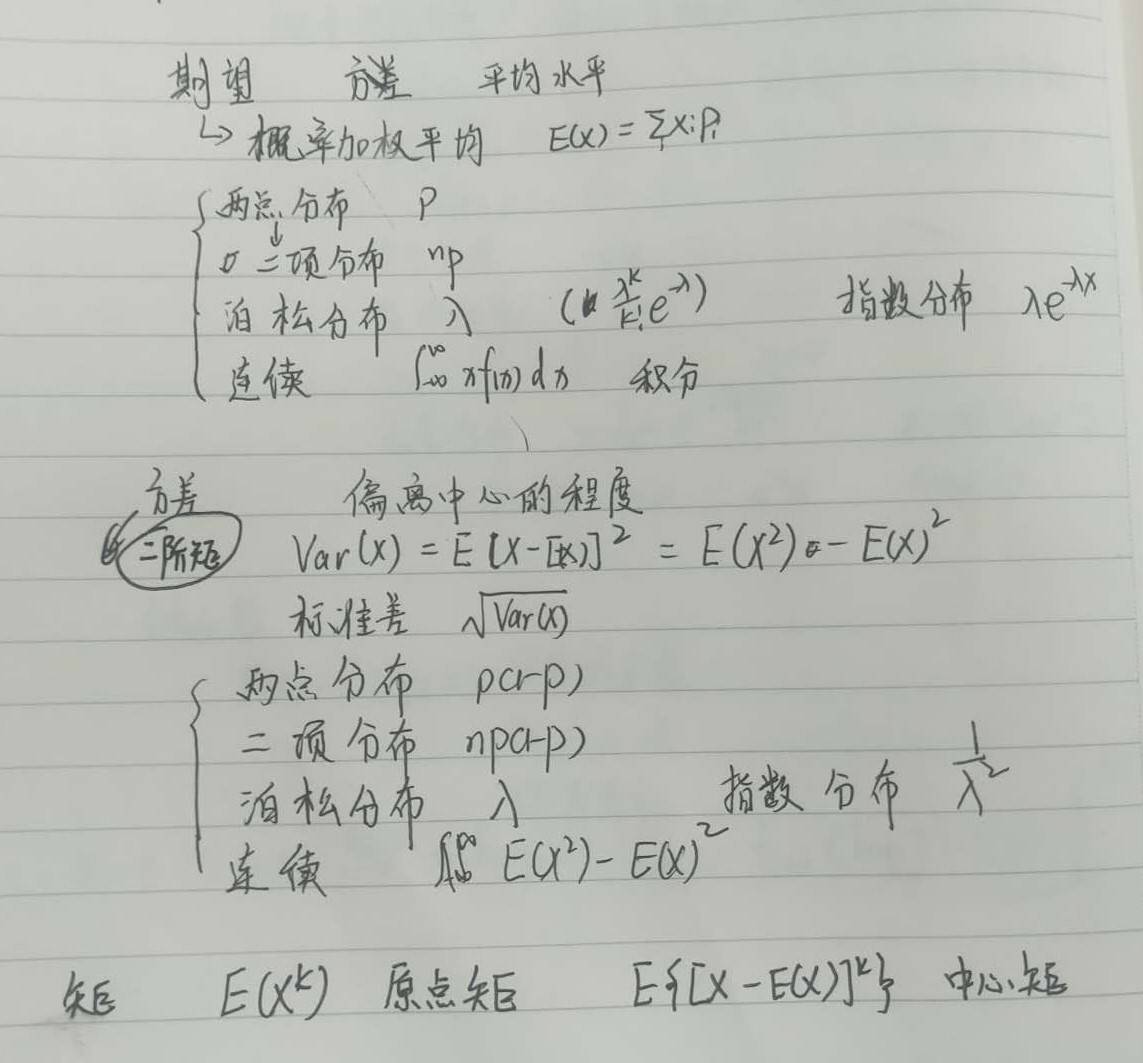

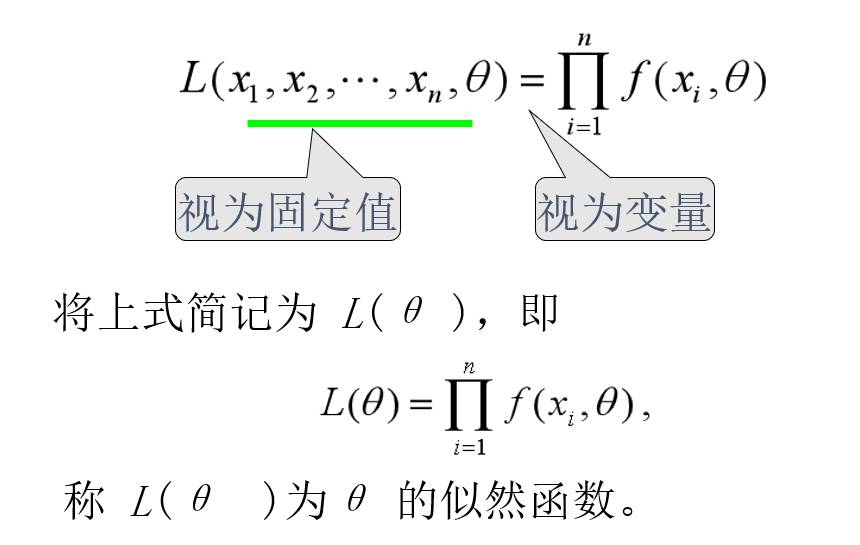

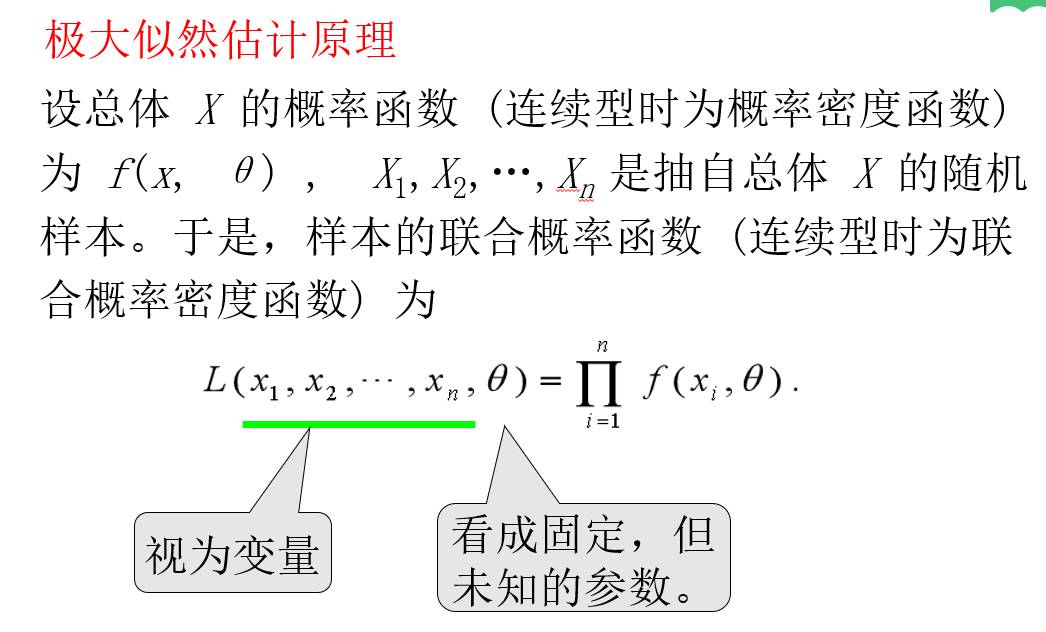

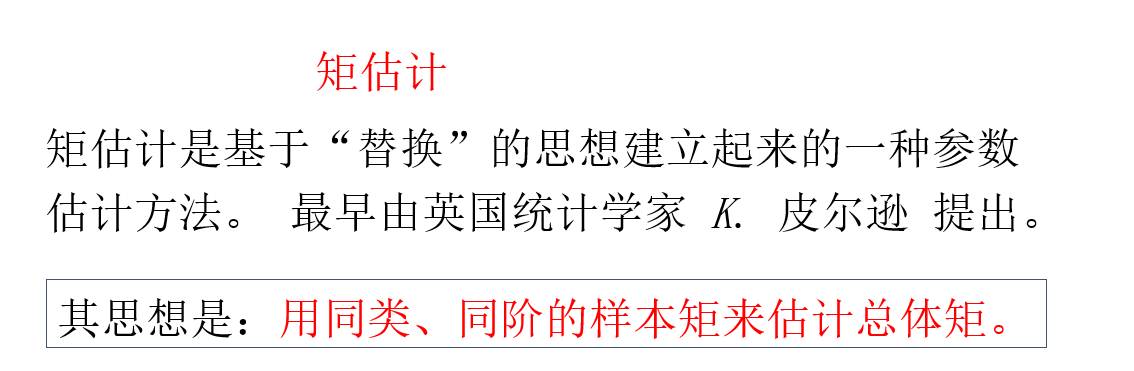

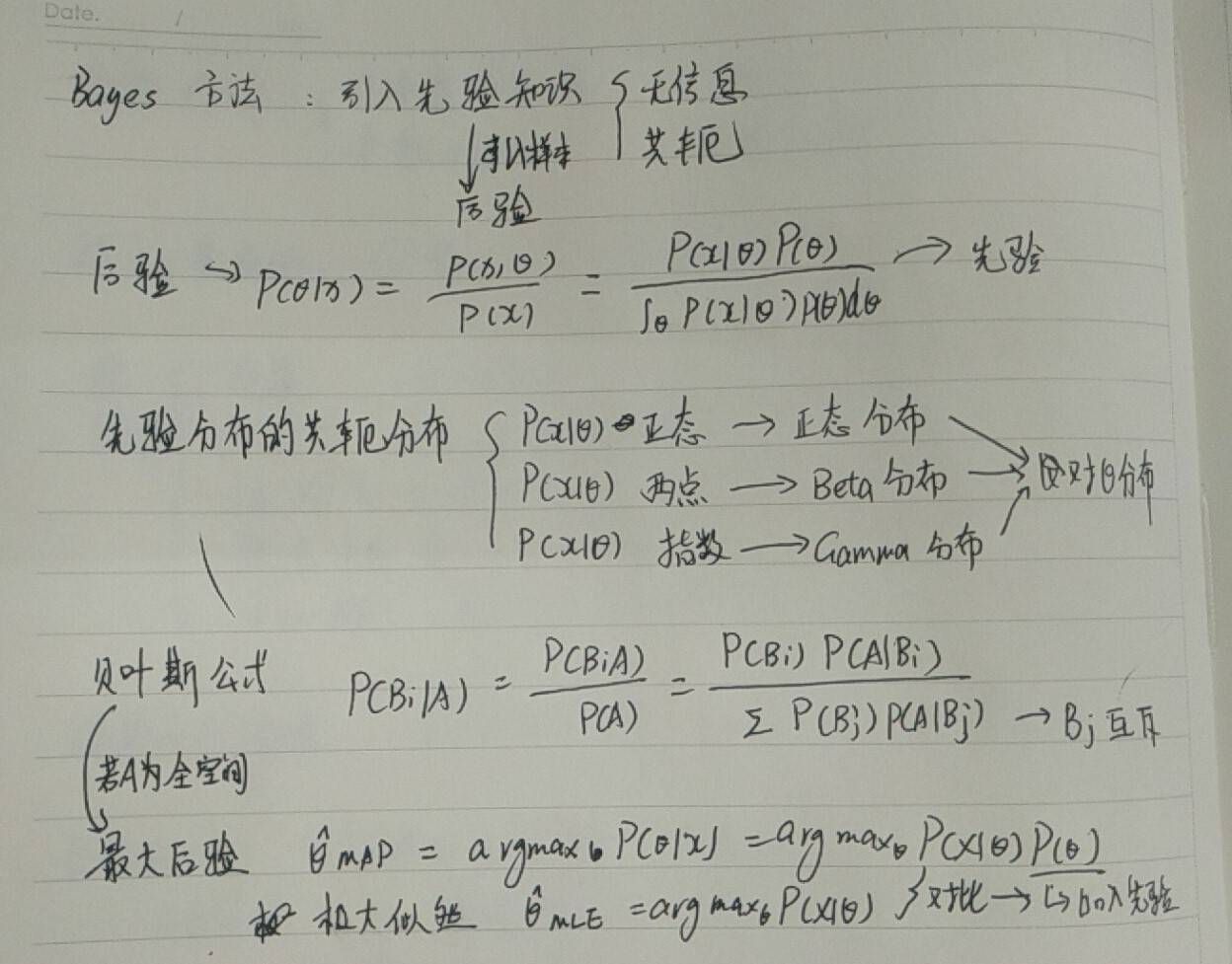

这节课讨论的主要内容是估计包括点估计矩阵估计最大似然估计。估计的含义就是根据样本区估计总体估计总体的参数如总体期望总体方差。二者的具体介绍

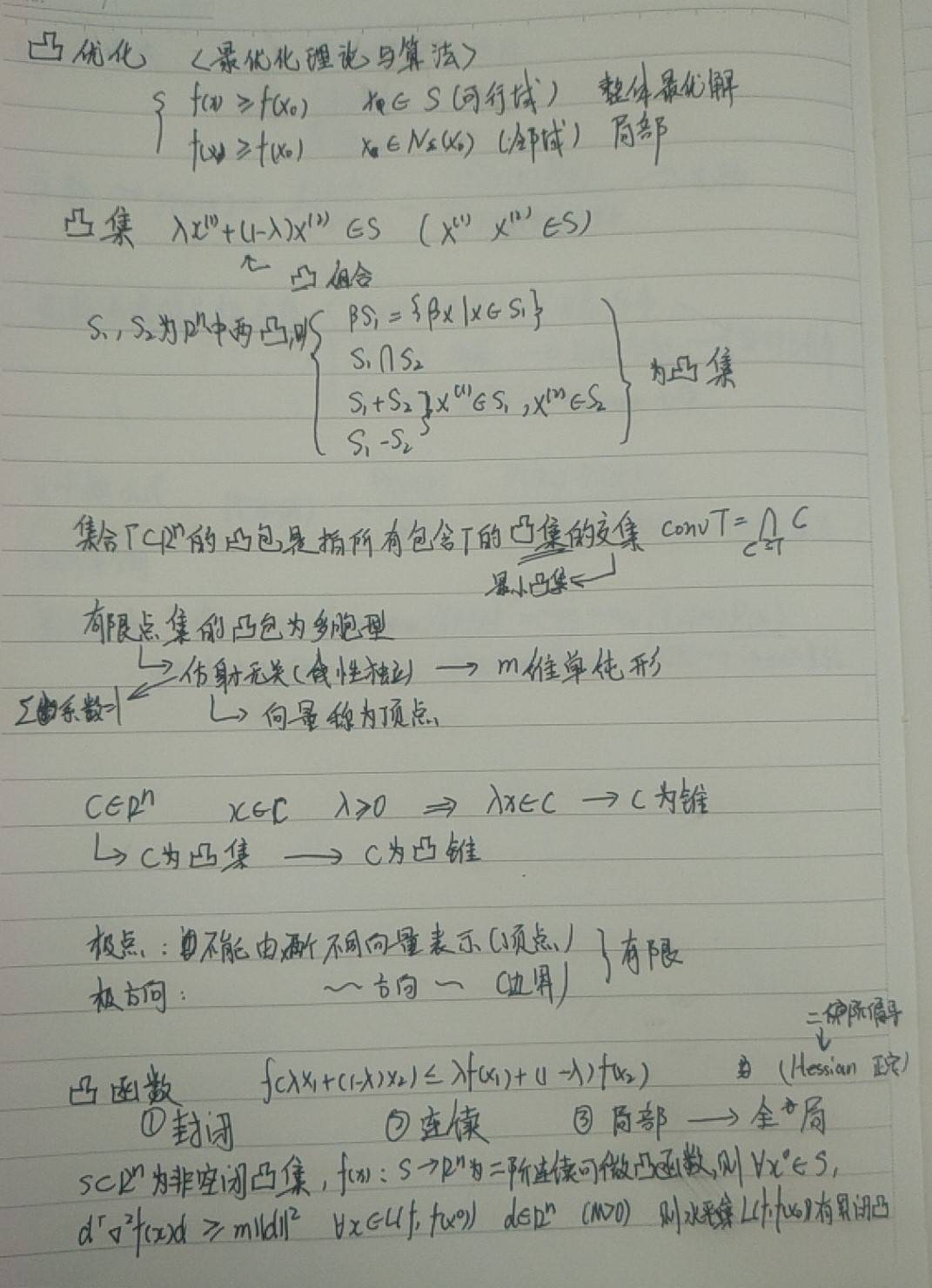

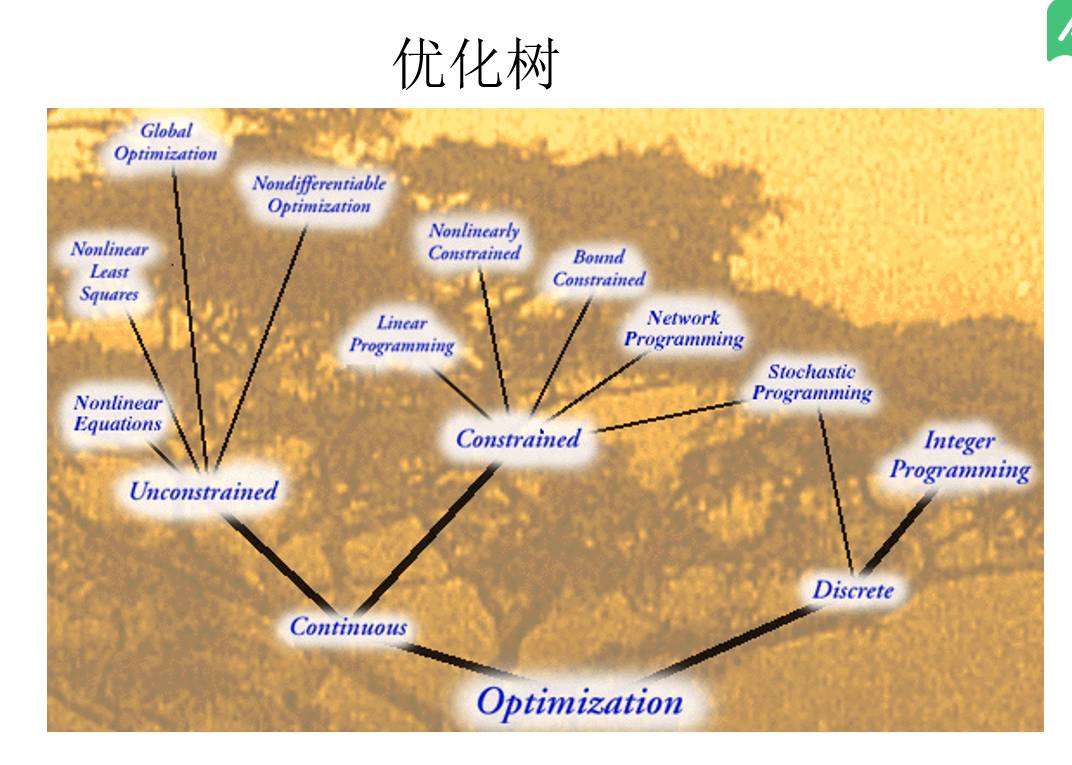

凸优化的第一课,概念内容比较多。

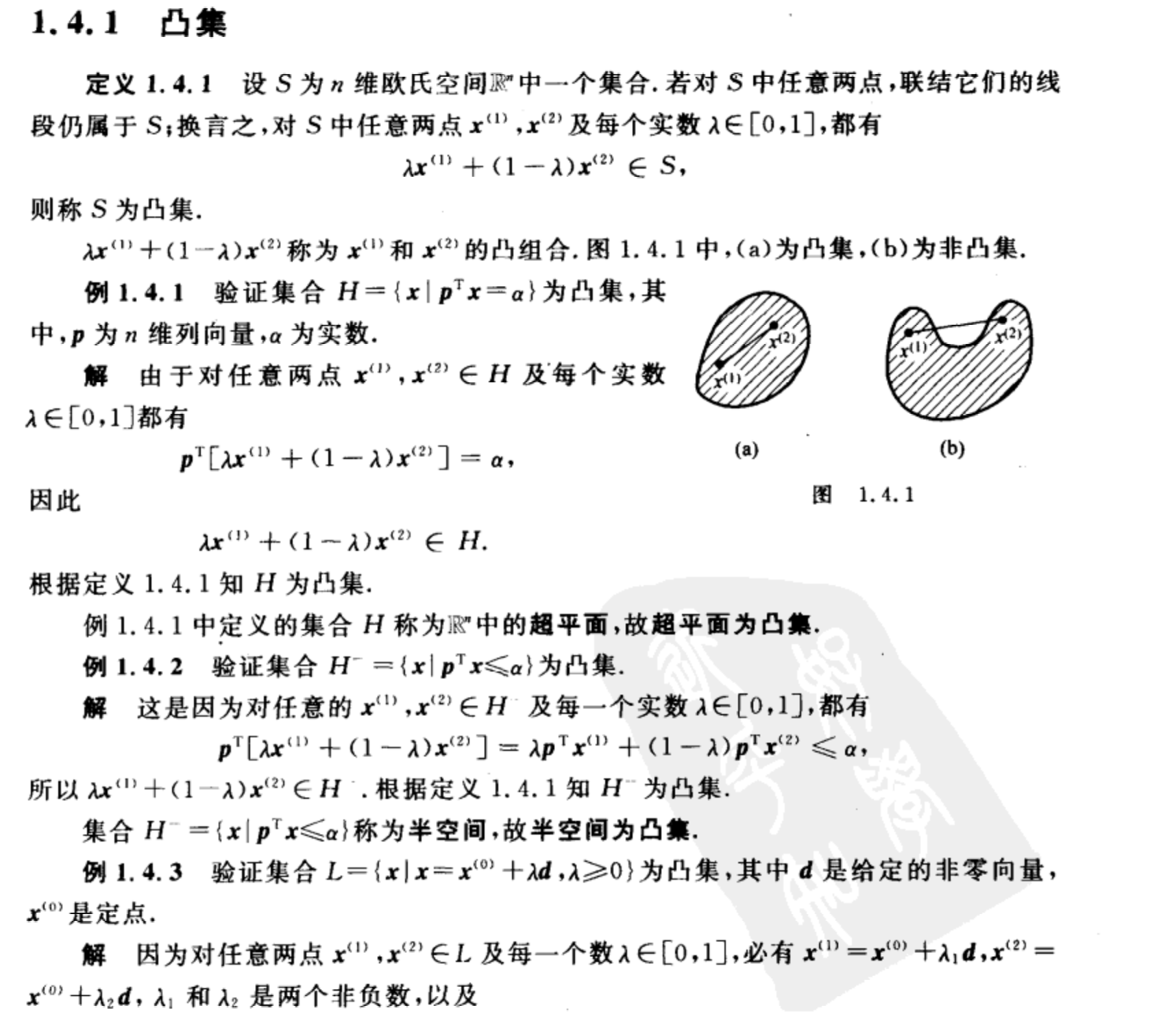

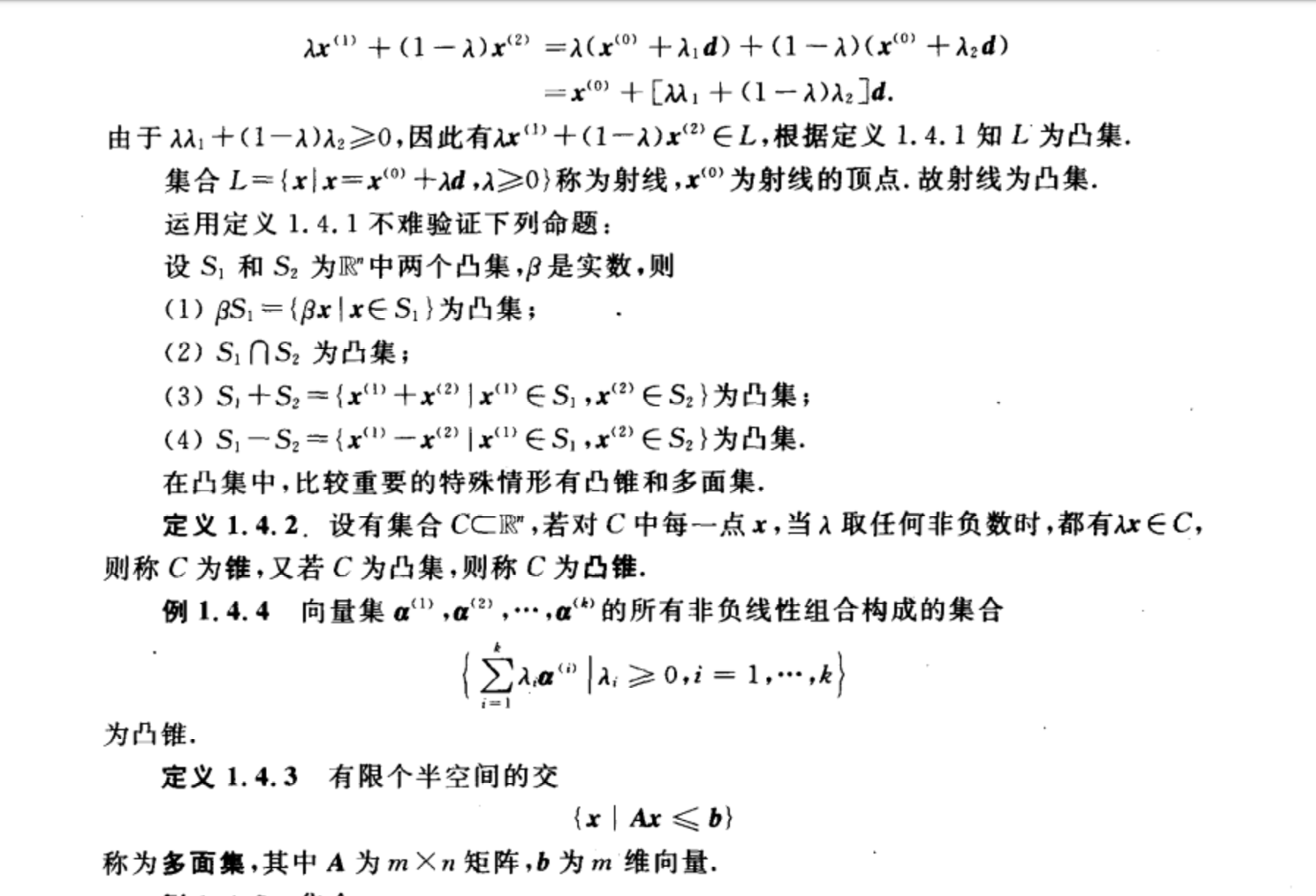

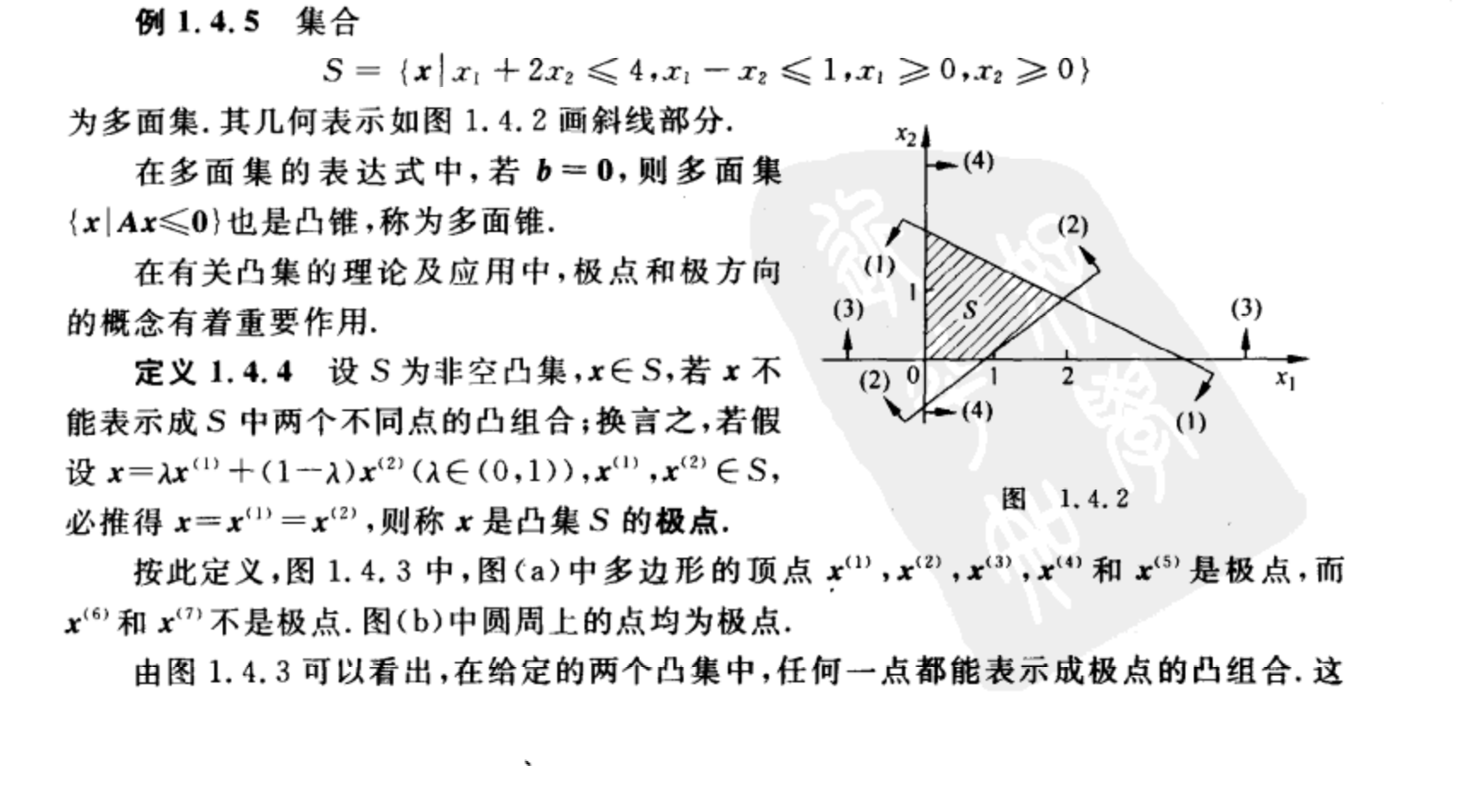

主要包括:凸集,超平面,半空间,锥,凸锥,射线,顶点,多面集,极点,极方向。参考老师给出的《最优化理论预算法》,具体概念和实例

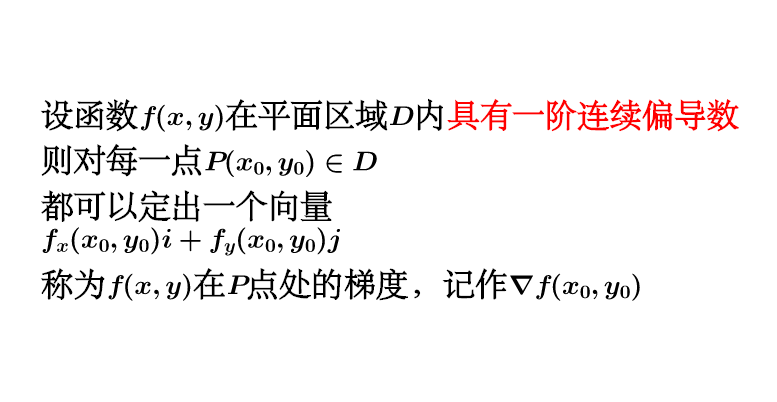

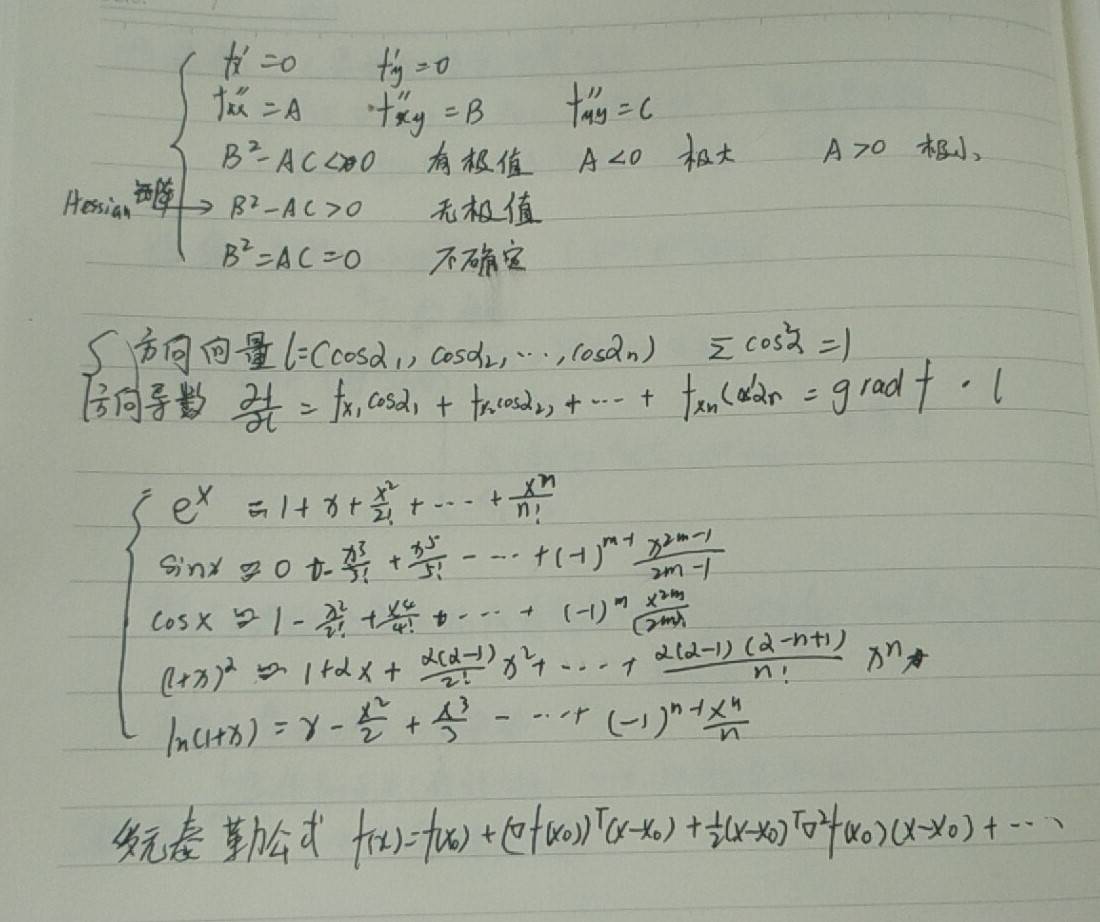

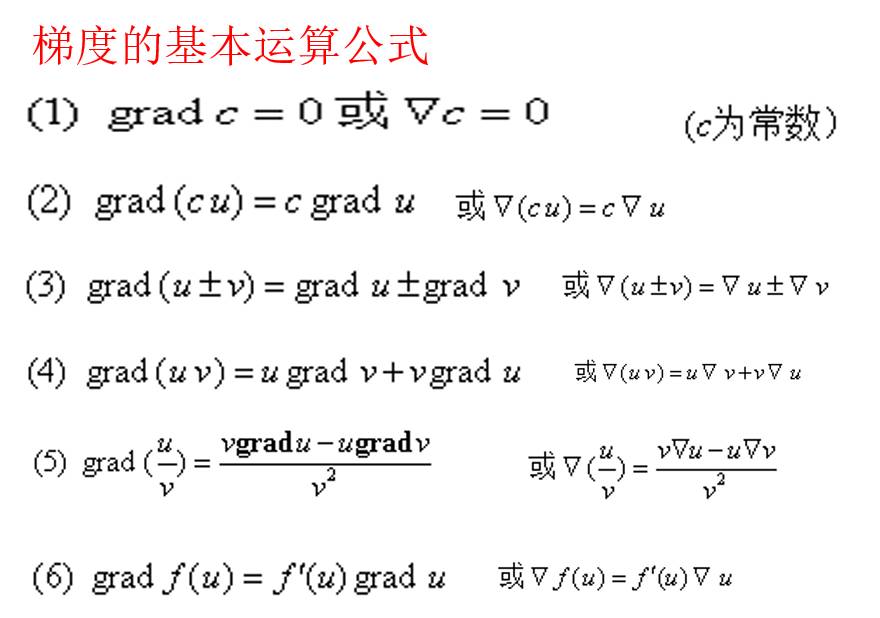

1.方向导数与梯度

方向导数是数值,表示某个方向上的导数

梯度为矢量,梯度方向上唯一存在最大的方向导数,梯度定义:

2.二元函数的极值判断:

2.二元函数的极值判断:

设:二元函数 f(x,y)的稳定点为:(x0,y0),即:∂f(x0,y0)/∂x = ∂f(x0,y0)/∂y = 0;记::A=∂²f(x0,y0)/∂x²B=∂²f(x0,y0)/∂x∂yC=∂²f(x0,y0)/∂y²∆=AC-B²

如果:∆>0 A0,f(x0,y0) 为极小值;如果:∆0f(0,0)=0 为最小值。

求解函数极值方法:寻求函数整个定义域上的最大值和最小值是数学优化的目标。如果函数在闭合区间上是连续的,则通过极值定理存在整个定义域上的最大值和最小值。此外,整个定义域上最大值(或最小值)必须是域内部的局部最大值(或最小值),或必须位于域的边界上。

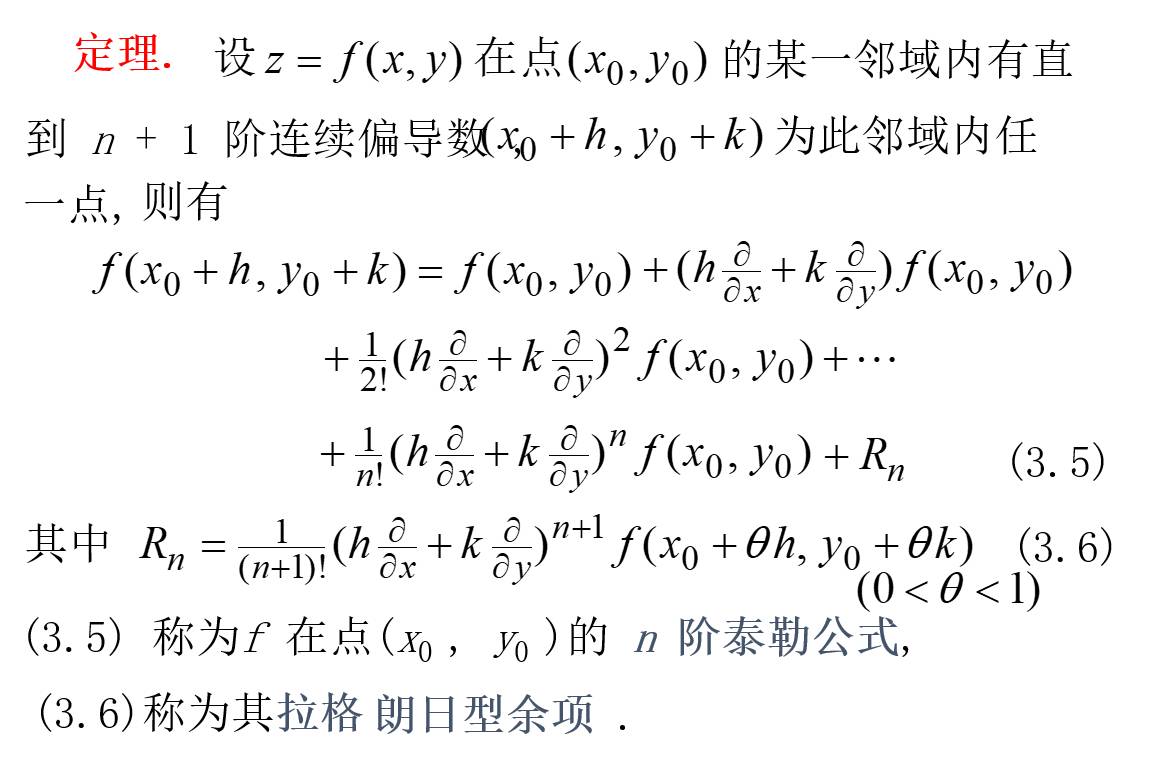

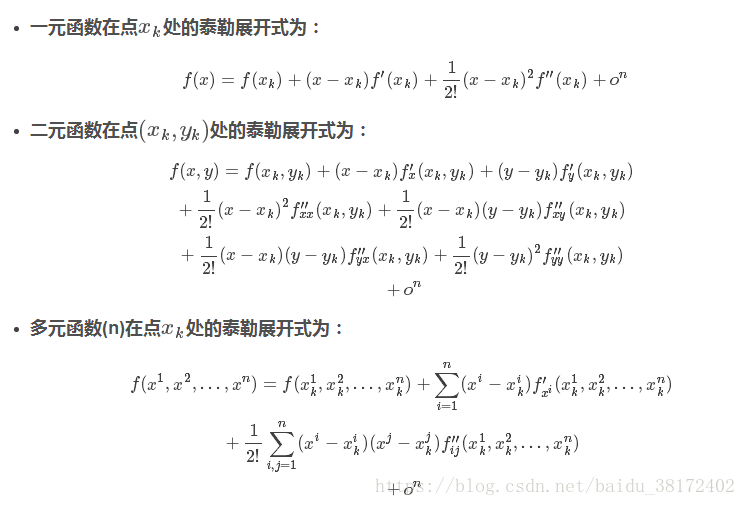

3.多元泰勒展开式:

进入到凸优化,难度比以前加强了,主要是概念和定理比较多,比较抽象化,需要结合画图和例题来进行梳理。

1可行下降方向:

定义一

定义二

2.起作用约束(active constraint)

亦称紧约束或积极约束,是指在某可行点处使不等式约束成为等式的约束。对于可行点x',当gi(x')=0时点x'处于这个约束形成的可行域的边界上,起到了限制作用,故称这一约束为点x'处的起作用约束,等式约束对所有可行点都是起作用约束。

3. 拉格朗日乘子

基本的拉格朗日乘子法(又称为拉格朗日乘数法),就是求函数 f(x1,x2,...) 在 g(x1,x2,...)=0 的约束条件下的极值的方法。其主要思想是引入一个新的参数 λ (即拉格朗日乘子),将约束条件函数与原函数联系到一起,使能配成与变量数量相等的等式方程,从而求出得到原函数极值的各个变量的解

4.KKT条件

min.:f(x)

s.t.:gi(x)≤0,i=1,2,…,p,

hj(x)=0,k=1,2,…,q,

x∈Ω⊂Rn

KKT条件是指在满足一些有规则的条件下, 一个非线性规划(Nonlinear Programming)问题能有最优化解法的一个必要和充分条件. 这是一个广义化拉格朗日乘数的成果. 一般地, 一个最优化数学模型的列标准形式参考开头的式子, 所谓 Karush-Kuhn-Tucker 最优化条件,就是指上式的最优点x∗必须满足下面的条件:

- 1. 约束条件满足gi(x∗)≤0,i=1,2,…,p, 以及,hj(x∗)=0,j=1,2,…,q

- 2. ∇f(x∗)+∑i=1pμi∇gi(x∗)+∑j=1qλj∇hj(x∗)=0, 其中∇为梯度算子;

- 3. λj≠0且不等式约束条件满足μi≥0,μigi(x∗)=0,i=1,2,…,p

更多概念参考:https://blog.csdn.net/weixin_37352167/article/details/84675233

相关课程

客服1

客服1

官方群

官方群