神经元: 放射变换(带bias)+ 符号运算

activation : relu、tanh、sigmoid

deep:dag最长路径

mlp: bool运算、实数运算

模拟一个真值表需要多深的网络,单层网络参数多2的n次方级别

多层网络logn,

固定层数网络 c*n

¥

支付方式

请使用微信扫一扫 扫描二维码支付

请使用支付宝扫一扫 扫描二维码支付

神经元: 放射变换(带bias)+ 符号运算

activation : relu、tanh、sigmoid

deep:dag最长路径

mlp: bool运算、实数运算

模拟一个真值表需要多深的网络,单层网络参数多2的n次方级别

多层网络logn,

固定层数网络 c*n

1.2 神经计算的历史和认知基础

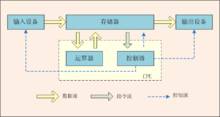

1.冯·诺依曼体系结构

2.神经元(大脑中的信息连接、处理单元)

细胞体(细胞核、细胞膜、细胞质)和突起(树突、轴突、轴突末梢)

3.感知机 Perceptron(模拟人类视神经控制系统的图形识别机)

4.布尔函数 0 1 与或非 同或 异或 组合 其他逻辑运算

5.输入 权重 参数 运算 输出 阈值比较

激活函数

阙(que一声)值,阈(yu四声)值,阀(fa二声)值。正规用法为阈值。意为 “临界值”。是指一个效应能够产生的的最低值或最高。

多层感知机(MLP):映射一组输入向量到一组输出向量

6.神经网络的建模

7. 好好学英语!好好学英语!好好学英语!

讲解了神经网络的起源,联结主义。信息存储在神经元的连接处。现代的神经网络及源于19世纪。

神经网络已经成为热点领域,其中使用在模式识别以问题分析上,有很多成功领域的例子:

1.语音识别

Google翻译基于神经网络的机器翻译系统,可以说是目前最好的翻译系统。

2.图像分割和识别

基于系统分割的神经网络,在复杂的场景中对物体进行分类识别。

3.模式识别

AlphaGo基于神经网络,开发出了目前最好的围棋系统,

4.语义分析

给图片添加描述,都是使用了深度神经网络来完成,也是成功的应用领域。

5.其他的领域

艺术、天文、医疗、股市预测都是可以从AI中得到了一定的好处。

艺术、天文、医疗、股市预测都是可以从AI中得到了一定的好处。

神经网络是一个通用逼近器

1⃣.感知机一般包含的元素

2⃣前馈神经网络

重点是没有循环在信号传播的过程中永远不会返回前面一个信号。这就相当于所有的计算都是单向的非循环的。当然循环神经网络也是非常重要的

3⃣有了神经网络如何使得神经网络能够按照特定的规则进行执行

学习神经网络的过程就是决定参数值的过程这个过程实际上就是使得神经网络能够输出我们想要的函数。前提是我们的这个神经网络有能力构建我们的目标函数。

0) 训练神经网络的结果可能得到的函数不是唯一的如何衡量所得到的函数好坏就需要指定一定的度量方式

1在实际中衡量预测值与真实值之间的差距并非只有一种度量方式重要的是多次之间的差异不能存在抵消的情况

2神经网络在逼近函数的过程中我们提供的数据不能是函数中每一个点的值这就意味着我们的训练样本实际上一个抽样的样本

3 样本训练过程中要求一个x只能对应一个唯一的输出值

4⃣多层感知机

感知机实际上就是寻找到一个超平面将正负样本进行分开其中权重与超平面是一个正交的关系在更新权重的过程中采取的策略就是权重方向指向正样本远离负样本。

在整个更新权重的过程中修正权重W的次数是有限的不会超过(R/γ)^2,其中R是最远的那个训练样本的距离γ是训练样本与超平面最近的距离.

应用:语音识别、机器翻译、图像分割、自动驾驶、下棋。照片转化为文字描述

不再是简历上的加分项,没有会扣分。

每天都有巨大的变化。

课程将包括理论与实践。

介绍相关课程信息。

神经网络就相当于一个黑盒子,可以通过构建这个盒子,实现语言识别、视频描述、游戏决策。

起源:联结主义。

信息储存在神经元与神经元的连接中。

第二课笔记:本节课主要介绍了神经网络的发展历史。起源于对大脑神经元的模仿,最开始只是简单的单独感知机模型,可以完成与或非布尔运算,但是不能完成异或运算。之后将感知机组成网络,多层感知机就出现了!多层感知机可以联结多个计算模型以此来耦合复杂布尔函数。之后的发展便是从布尔型机器,到可以处理实数,从硬阈值到软阈值,至此MLP(多层感知机)可用于图像分类,甚至是复杂函数的拟合。

所谓往往越简单的越是强大!小小的感知机在组成MLP后,会有很强大的功能。