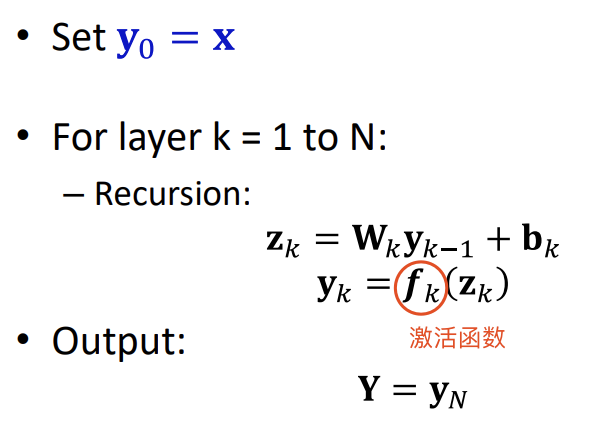

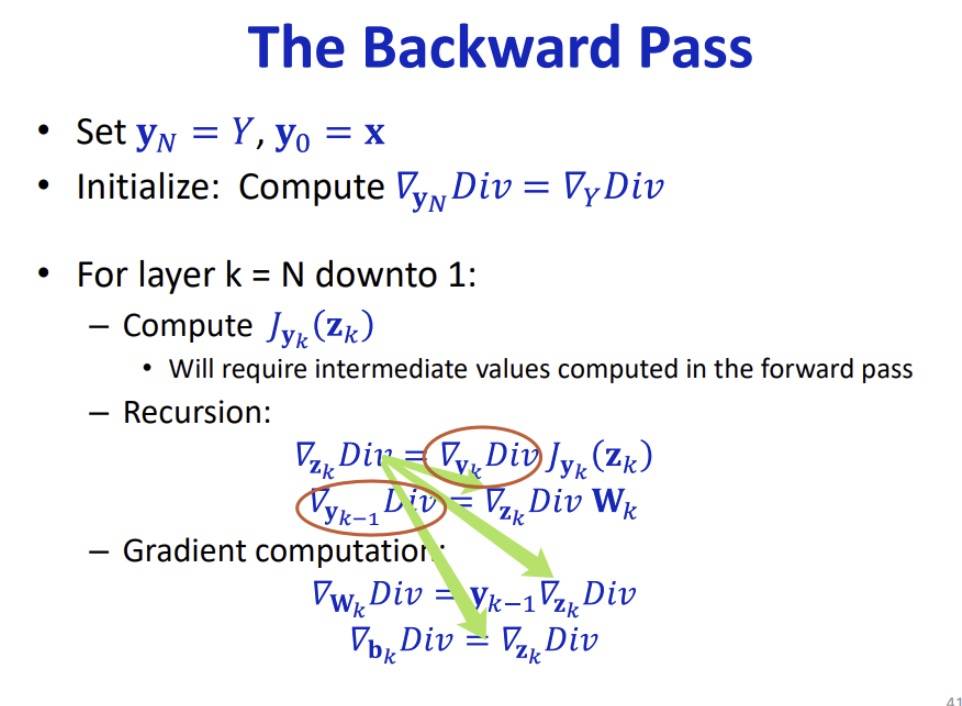

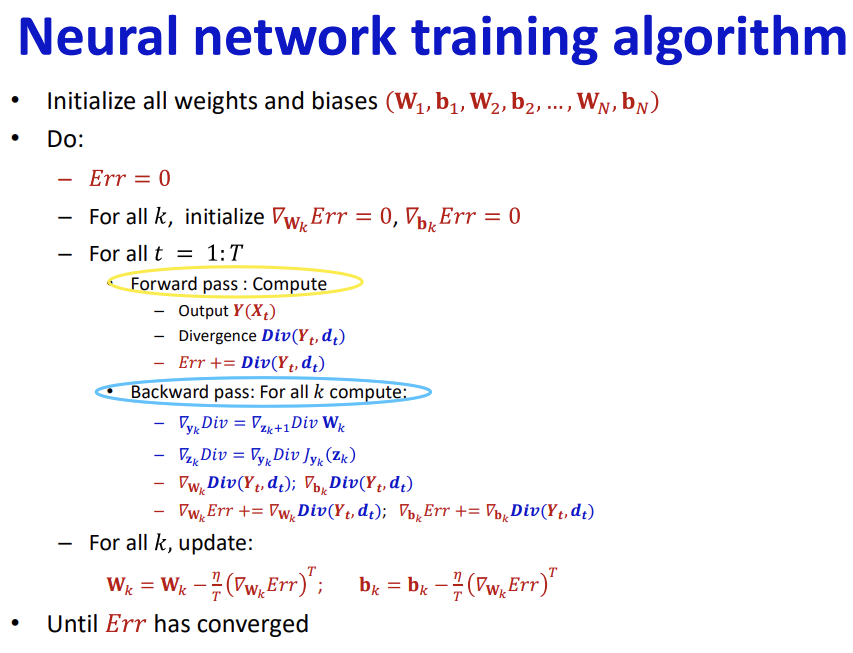

网络利用偏导数和散度反向计算前一轮W+b产生的误差。利用链式求导反向计算,前一层利用后一层回传的导数来计算自己的偏差,只需一次计算不用反复计算。

梯度计算与感知机的区别

梯度计算异常点对其影响不大,有可能出现误分情况。感知机会对每一个类别进行区分,异常点对其影响很大,计算过程可能会较大。

梯度下降在样本大时会产生多种鞍点容易陷入局部最优。在链式过长时可能梯度消失,softmax可能会产生梯度爆炸。

¥

支付方式

请使用微信扫一扫 扫描二维码支付

请使用支付宝扫一扫 扫描二维码支付

网络利用偏导数和散度反向计算前一轮W+b产生的误差。利用链式求导反向计算,前一层利用后一层回传的导数来计算自己的偏差,只需一次计算不用反复计算。

梯度计算与感知机的区别

梯度计算异常点对其影响不大,有可能出现误分情况。感知机会对每一个类别进行区分,异常点对其影响很大,计算过程可能会较大。

梯度下降在样本大时会产生多种鞍点容易陷入局部最优。在链式过长时可能梯度消失,softmax可能会产生梯度爆炸。

感知机与后向传播的区别

1对于感知机当训练样本中加入一个新的样本感知机分类器有可能会发生较大的变化

(2) 后向传播当训练样本中加入一个新的样本汇总将会有较小的改动。这就意味着不会因为一个样本的change网络发生较大的变化。