计算机视觉中,将低级特征逐渐提取,(如HOG-SVM),逐渐高级,使用深度神将网络能够端到端地学习其中特征。

传统强化学习使用特征标识,需要标识特质和值函数,而使用深度神经网络,可以实现端到端的特征提取。

¥

支付方式

请使用微信扫一扫 扫描二维码支付

请使用支付宝扫一扫 扫描二维码支付

计算机视觉中,将低级特征逐渐提取,(如HOG-SVM),逐渐高级,使用深度神将网络能够端到端地学习其中特征。

传统强化学习使用特征标识,需要标识特质和值函数,而使用深度神经网络,可以实现端到端的特征提取。

先导部分可以在一下网站学习:https://www.tensorflow.org/guide/low_level_intro

要精通Python

课程内容:

1.From supervised learning to decision making problems

2.Model-free algorithms: Q-learning, policy gradients, actor-critic

3.Model-based reinforcement learning and some advanced topics and prediction

4.Exploration

5.Transfer and multi-task learning, meta-learning

6.Open problems, research talks, invited lectures

deep learning helps us handle unstructured environments

but doesn't tell us anyuthing about decision-making

RL gives us the mathematical framework for dealing with decision making

In RL, we have an agent that makes decisions we should call actions

the world responds with consequences we should call observations and rewards

RL actually generalizes many other machine learning

Why should we study this now

1.Advances in DL

2.Advances in RL

3.Advances in computational capability

Beyond learning from reward

Basic RL deals with maximizing rewards

This is not the only problem that matters for sequential decision making!

We will cover more advanced topics

Learing reward functions from example (inverse RL)

Transferring knowledge between domains (transfer learning, meta-learning)

Where do rewards come from?

Game --> score

well-defined notion of success might be very difficult to measure

What can DL & RL do well now?

Acquire high degree of proficiency in domains governed by simple, known rules

Learn simple skills with raw sensory inputs, given enough experience

Learn from imitating enough human-provided expert behavior

What has proven challenging so far?

Humans can learn incredibly quickly

Deep RL method are usually slow

Humans can reuse past knowledge

Transfer learning in deep RL is an open problem

Not clear what the reward function should be

强化学习第一课

1:如何建立一个智能机器

强化学习为非结构化环境中的学习提供了一种形式。代理与环境之间通过决策与反馈进行学习。

2:什么是深度强化学习,为何关注它

深度学习提供了端到端的训练学习,好处是不用人的手动调节,本身是自适应的目标最优化的过程。

强化学习在现实中的限制为:找到正确的特征使得增强学习算法表现优异。

3:端到端学习对决策的意义

端到端的学习节省时间,不用人工手动调节。

深度模型使强化学习算法可以端到端的解决复杂问题。

4:为何是现在

深度学习、强化学习、计算机算力已经取得了突破性的进展。

5:深度强化学习的基本概念

深度学习部分:处理复杂的感知输入。

强化学习部分:选择复杂的行动。

这门课得先修课程是 CS189 CS289 CS281A,

这门课主要使用Tensorflow。

第一讲主要介绍了强化学习以及很多应用的实例。

智能体通过action与环境交互并获得相应的回报,强化学习通过最大化汇报得出一系列合理化的动作。

强化学习适合在一些简单且已知的环境中,强化学习可以直接处理源信息,并且可以模仿出人类专家的行为。

挑战:

强化学习学习起来比较慢

强化学习在利用已有经验方面(transfer learning)存在问题。

回报的合理化定义仍是问题

关于预测的的角色仍不清晰(大力发展基于模型还是无模型的强化学习)

1. 模仿学习

2. 通过观察世界学习

2.1 预测; 2.2 非监督学习

3. 从其他任务中学习

3.1 迁移学习(不同领域之间的知识迁 移) 3.2 Meta-learning

1. 通过机器人科幻小说引入话题:如何build intelligent machines? 我们现今的科技与未来的机器人差距在哪里?现今的技术能完成怎样的任务?

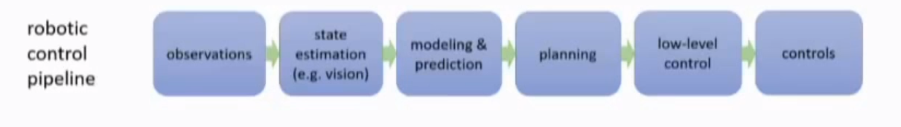

2. 深度学习直接根据raw sensor signal来可以处理unstructured environments

3. 机器人不仅要识别环境,还要根据此作出decision,RL 提供一个mathematical formalism for decision.

4. 过去的RL一些学习特征需要人为设计,而深度学习则能帮助RL端到端的学习更为复杂问题。好处在于:

4.1. 不用人为设计特征

4.2. 可以自动学习到最优策略

5. 2018是学习DRL的好时机:

5.1 Advances in DL

5.2 Advances in RL

5.3 Advances in Computational Capability

6. RL与DL结合产生出更强效果的idea早25年已经出现,但一直都缺乏一些正确的细节technique来使其变得有实际意义。

7. Reward在现实任务中很难定义

7.1 Imitation Learning

7.2 Inverse RL

8. Why DRL?

8.1 Deep = can process complex sensory input, and also compute really complex functions.

8.2 RL = can make decision