第2章 马尔科夫决策过程 02

课时5 马尔科夫奖赏过程

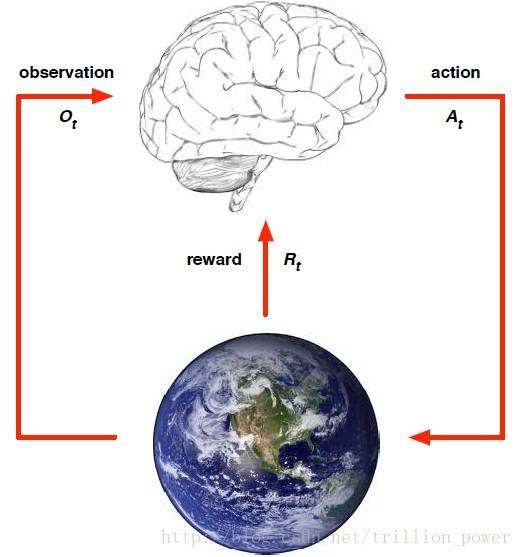

马尔科夫决策过程正式描述了强化学习的环境。

因此此环境是可以全部观察的

几乎所有的强化学习问题都可以提炼成一个MDP问题。

1、马尔可夫性

定义:状态St 是马尔科夫的,当且仅当满足

即t+1时刻的状态St+1的概率只与St有关,而与其他状态无关。

2、状态转移概率

矩阵形式

3、马尔科夫链(Markov chain)

马尔科夫链是一个无记忆的随机过程,即随机过程中的状态序列具有马尔可夫性。

定义:马尔科夫链表示为<S, P>,其中 S 是状态集,P是状态转移概率矩阵。

一般用状态转移图来表示。例如:

写成概率矩阵形式为:

4、奖赏过程

定义:<S, P, R, r>,其中S是状态集,P是状态转移概率矩阵,R是奖赏函数,r是折扣系数。

值函数(value function):值函数是未来奖赏值的预测,可以用来评估当前状态的好坏,agent可以根据此来选择要执行的动作。

值函数可以被分解为两个部分

后面的方程称为贝尔曼方程,是一个迭代的方程。

对这个推导的图解表示

计算实例:略。

5、贝尔曼方程

MRP矩阵形式:v = R + r P v,其中v是一个列向量

要解贝尔曼方程,只需要通过如下推导,就能得到等式,所以只需要求得相关转移概率的逆矩阵就可以求解贝尔曼方程:

p.s. :动态规划是解这个方程的一套方法。

客服1

客服1

官方群

官方群