强化学习是机器器学习领域之⼀一,受到⾏行行为⼼心理理学的启发,主要关注智能体如何在环境中采取不不同的⾏行行动, 以最⼤大限度地提⾼高累积奖励。 智能体通过强化学习,可以知道⾃自⼰己在什什么状态下,应该采取什什么样的动作使得⾃自身获得最⼤大奖励。由 于智能体与环境的交互⽅方式与⼈人类与环境的交互⽅方式类似,可以认为强化学习是⼀一套通⽤用的学习框架,可⽤用 来解决通⽤用⼈人⼯工智能的问题。因此强化学习也被称为通⽤用⼈人⼯工智能的机器器学习⽅方法。

¥

支付方式

请使用微信扫一扫 扫描二维码支付

请使用支付宝扫一扫 扫描二维码支付

强化学习第一课

1:如何建立一个智能机器

强化学习为非结构化环境中的学习提供了一种形式。代理与环境之间通过决策与反馈进行学习。

2:什么是深度强化学习,为何关注它

深度学习提供了端到端的训练学习,好处是不用人的手动调节,本身是自适应的目标最优化的过程。

强化学习在现实中的限制为:找到正确的特征使得增强学习算法表现优异。

3:端到端学习对决策的意义

端到端的学习节省时间,不用人工手动调节。

深度模型使强化学习算法可以端到端的解决复杂问题。

4:为何是现在

深度学习、强化学习、计算机算力已经取得了突破性的进展。

5:深度强化学习的基本概念

深度学习部分:处理复杂的感知输入。

强化学习部分:选择复杂的行动。

这门课得先修课程是 CS189 CS289 CS281A,

这门课主要使用Tensorflow。

第一讲主要介绍了强化学习以及很多应用的实例。

智能体通过action与环境交互并获得相应的回报,强化学习通过最大化汇报得出一系列合理化的动作。

强化学习适合在一些简单且已知的环境中,强化学习可以直接处理源信息,并且可以模仿出人类专家的行为。

挑战:

强化学习学习起来比较慢

强化学习在利用已有经验方面(transfer learning)存在问题。

回报的合理化定义仍是问题

关于预测的的角色仍不清晰(大力发展基于模型还是无模型的强化学习)

- 深度强化学习:深度学习负责处理非结构化的环境(连续/随机/复杂/不可预测),就像AI的眼睛;而强化学习的部分则是构建一个行动决策体系,不断与环境交互获得奖励,并以最大化奖励函数为目标去寻找最优策略,相当于AI的决策中心。

- 强化学习问题其实是很多其他机器学习任务的泛化表示。例如NLP中的机器翻译可以用强化学习方式来解决。

- 对于真实世界中的连续决策问题(Sequential decision making) ,基本的奖励函数驱动的解决思路可能并不够,需要更多其他的解决方案。(课程后面会涉及到的高级主题)

1. 模仿学习

2. 通过观察世界学习

2.1 预测; 2.2 非监督学习

3. 从其他任务中学习

3.1 迁移学习(不同领域之间的知识迁 移) 3.2 Meta-learning

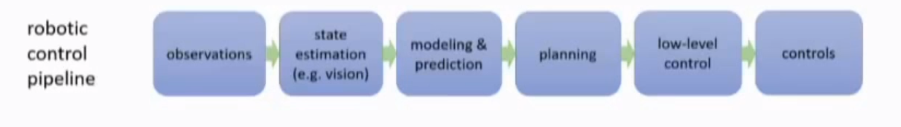

1. 通过机器人科幻小说引入话题:如何build intelligent machines? 我们现今的科技与未来的机器人差距在哪里?现今的技术能完成怎样的任务?

2. 深度学习直接根据raw sensor signal来可以处理unstructured environments

3. 机器人不仅要识别环境,还要根据此作出decision,RL 提供一个mathematical formalism for decision.

4. 过去的RL一些学习特征需要人为设计,而深度学习则能帮助RL端到端的学习更为复杂问题。好处在于:

4.1. 不用人为设计特征

4.2. 可以自动学习到最优策略

5. 2018是学习DRL的好时机:

5.1 Advances in DL

5.2 Advances in RL

5.3 Advances in Computational Capability

6. RL与DL结合产生出更强效果的idea早25年已经出现,但一直都缺乏一些正确的细节technique来使其变得有实际意义。

7. Reward在现实任务中很难定义

7.1 Imitation Learning

7.2 Inverse RL

8. Why DRL?

8.1 Deep = can process complex sensory input, and also compute really complex functions.

8.2 RL = can make decision

https://zhuanlan.zhihu.com/p/32727209

这个专栏写得很赞,建议看完课程之后浏览一下,会有很多收获

客服1

客服1

官方群

官方群